Re-Imagen: Retrieval-augmented text-to-image generator

公众号:EDPJ(添加 VX:CV_EDPJ 或直接进 Q 交流群:922230617 获取资料)

目录

0. 摘要

1. 简介

2. 相关工作

3. 模型

3.1 预备知识

3.2 用多模态知识生成图像

4. 实验

4.1 在 COCO 和 WikiImages 上的评价

4.2 EntityDrawBench 上的以实体为中心的评估

4.3 分析

5. 结论

6. 道德声明

参考

附录

A. 延伸文献综述

B. WikiImages 数据集

C. EntityDrawBench

E. 分类器无指导采样策略

G. 想象的例子

H. 与 DREAMBOOTH 的比较

I. 失败的例子

S. 总结

S.1 主要贡献

S.2 架构和方法

0. 摘要

在大规模图像文本数据训练的扩散和自回归模型的驱动下,文本到图像生成的研究在生成多样化和逼真的图像方面取得了重大进展。 尽管最先进的模型可以生成常见实体的高质量图像,但它们通常难以生成不常见实体的图像,例如“Chortai(狗)”或“Picarones(食物)”。 为了解决这个问题,我们提出了检索增强文本到图像生成器(Re-Imagen),这是一种生成模型,它使用检索到的信息来生成高保真和忠实的图像,即使对于罕见或未见过的实体也是如此。 给定文本提示,Re-Imagen 访问外部多模态知识库来检索相关(图像、文本)对,并将它们用作生成图像的参考。 通过此检索步骤,Re-Imagen 增强了所提及实体的高级语义和低级视觉细节的知识,从而提高了生成实体视觉外观的准确性。 我们在包含(图像、文本、检索)三元组的构建数据集上训练 Re-Imagen,以教导模型基于文本提示和检索。 此外,我们开发了一种新的采样策略来交织文本和检索条件的无分类器指导,以平衡文本和检索对齐。 与 COCO 和 WikiImage 相比,Re-Imagen 在 FID 分数上取得了显着提高。 为了进一步评估模型的功能,我们引入了 EntityDrawBench,这是一个新的基准,可以评估从频繁到罕见的多种对象类别(包括狗、食物、地标、鸟类和人物)的图像生成。 对 EntityDrawBench 的人工评估表明,Re-Imagen 可以显着提高生成图像的保真度,尤其是在不常见的实体上。

1. 简介

最近关于条件生成模型的研究工作,

- 例如 Imagen (Saharia et al., 2022)、DALL E 2 (Ramesh et al., 2022) 和 Parti (Yu et al., 2022),已经推进了文本到图像生成达到前所未有的水平,生成准确、多样化,甚至可以根据文本提示创建图像。

- 这些模型利用网络(Web)规模(具有数亿个训练示例)的成对图像文本数据和强大的骨干生成模型,即自回归模型(Van Den Oord 等人,2017 年;Ramesh 等人,2021 年;Yu 等人, 2022)、扩散模型(Ho et al., 2020;Dhariwal & Nichol, 2021)等,并生成高度逼真的图像。

- 研究这些模型的生成结果,我们发现它们的输出对文本提示中实体(或对象)的频率非常敏感。特别是,当生成有关频繁出现的实体的文本提示时,这些模型通常会生成逼真的图像,忠实地反映实体的视觉外观。 然而,当从不太频繁的实体的文本提示生成时,这些模型要么幻觉不存在的实体,要么输出相关的频繁实体(见图 1),无法在生成的图像和提到的实体的视觉外观之间建立联系。

- 这一关键限制可能会极大地损害文本到图像模型在现实应用中的可信度,甚至引发道德问题。在我们的研究中,我们发现这些模型在生成与代表性不足的群体相关的视觉对象时,质量明显下降。

在本文中,我们提出了一种检索增强的文本到图像生成器(Retrieval-augmented Text-to-Image Generator,Re-Imagen),它通过在多模态知识库中搜索实体信息而不是试图记住稀有实体的外观来缓解这种限制。

- 具体来说,我们定义多模态知识库,使用参考 <图像,文本> 对的集合对实体的视觉外观和描述进行编码。

- 为了使用该资源,Re-Imagen 首先使用输入文本提示从外部多模态知识库中检索最相关的<图像,文本>对,然后使用检索到的知识作为模型附加输入来合成目标图像。

- 因此,检索到的参考文献提供了有关所提及实体的语义属性和具体视觉外观的知识,以指导 Re-Imagen 在目标图像中绘制实体。

Re-Imagen 的骨干是一个级联扩散模型(Ho et al., 2022),其中包含三个独立的生成阶段(实现为 U-Nets(Ronneberger et al., 2015))以逐渐产生高分辨率(即 第1024章 1024)图像。

- 特别是,我们在由 Imagen 使用的图像文本数据集构建的数据集上训练 Re-Imagen(Saharia 等人,2022),其中每个数据实例关联数据集中的前 k 个最近邻相(基于仅文本的 BM25 分数)。 检索到的前 k 个 <图像,文本> 对将用作模型关注的参考。

- 在推理过程中,我们设计了一个交错的指导计划,可以在文本指导和检索指导之间切换,从而确保文本对齐和实体对齐。

- 我们展示了 Re-Imagen 生成的一些示例,并将它们与图 1 中的 Imagen 进行比较。我们可以定性地观察到我们的图像更忠实于参考实体的外观。

为了进一步定量评估 Re-Imagen,

- 我们在两个具有挑战性的数据集上展示了零样本文本到图像生成结果:COCO(Lin 等人,2014)和 WikiImages(Chang 等人,2022)(原始 WikiImages 数据库包含 <实体图像,实体描述> 对。 它是从维基共享资源中抓取的,用于视觉问答,我们在这里将其重新用于文本到图像的生成)。

- Re-Imagen 使用外部不重叠的图文数据库作为检索的知识库,然后根据检索合成目标图像。

- 我们表明,在非微调模型中,Re-Imagen 在 COCO 和 WikiImages 上实现了最先进的文本到图像生成性能,以 FID 分数衡量(Heusel 等人,2017)。对于非以实体为中心的数据集 COCO,性能增益来自于模型的偏置,以生成与检索的域内图像风格相似的图像。对于以实体为中心的数据集 WikiImages,性能增益来自于将生成基于包含相似实体的检索图像。

- 我们在更具挑战性的基准 EntityDrawBench 上进一步评估 Re-Imagen,以测试模型在不同场景中生成各种不常见实体(狗、地标、食物、鸟类、动画角色)的能力。我们将 Re-Imagen 与 Imagen (Saharia et al., 2022)、DALLE 2 (Ramesh et al., 2022) 和 StableDiffusion (Rombach et al., 2022) 在忠实度和真实感方面与人类评分者进行比较。我们证明,Re-Imagen 可以在超过 80% 的输入提示下生成忠实且真实的图像,在 EntityDrawBench 上比现有最佳模型至少高出 30%。 分析表明,改进主要来自低频视觉实体。

总而言之,我们的主要贡献是:

- 一种新颖的检索增强文本到图像模型 Re-Imagen,它提高了两个数据集上的 FID 分数;

- 采样过程中交错的无分类器指导,以确保文本对齐和实体保真度(对齐);

- 我们引入 EntityDrawBench 并表明 Re-Imagen 可以显着提高对不常见实体的忠实度。

2. 相关工作

文本到图像扩散模型。

- 在使用扩散模型对文本到图像的生成进行建模方面取得了广泛的成功(Ashual 等人,2022 年;Ramesh 等人,2022 年;Saharia 等人,2022 年;Nichol 等人,2021 年),在真实感和多样性(在相似模型大小下)方面优于 GAN(Goodfellow 等人,2014)和自回归 Transformers(Ramesh 等人,2021),并且没有训练不稳定和模式崩溃问题。

- 其中,一些最近的大型文本到图像模型,如 Imagen (Saharia et al., 2022)、GLIDE (Nichol et al., 2021) 和 DALL-E2 (Ramesh et al., 2022) 都表现出了基于复杂提示输入的出色生成能力 。这些模型通过文本输入实现对生成图像的高度细粒度控制。

- 然而,它们并没有明确地以外部视觉知识为基础,并且仅限于记住其参数中每个可能的视觉实体的视觉外观。 这使得它们很难推广到罕见甚至未见过的实体。

- 相比之下,Re-Imagen 旨在使扩散模型免于记忆,因为鼓励模型从知识库中检索语义近邻,并使用检索作为上下文来绘制图像。 Re-Imagen 改进了扩散模型对现实世界知识的基础,因此能够进行忠实的图像合成。

同期工作。有几项同期工作(Li et al., 2022;Blattmann et al., 2022;Ashual et al., 2022)也利用检索来改进扩散模型。

- RDM (Blattmann et al., 2022) 的训练方式与 Re-Imagen 类似,使用示例和近邻,但 RDM 中的邻域是使用图像特征选择的,并且在推理时检索被用户选择的示例替换。 RDM 被证明可以有效地从范例到生成的图像迁移艺术风格。

- 相比之下,我们提出的在文本和多模态近邻上生成图像的 Re-Imagen 条件包括推理时的检索,并被证明可以提高稀有图像(以及更普遍的图像)的性能。

- KNN-Diffusion(Ashual 等人,2022)是与我们更密切相关的工作,因为它也使用检索来生成图像的质量。

- 然而,KNN-Diffusion 使用离散图像表示,而 Re-Imagen 使用原始像素,并且 Re-Imagen 检索到的邻居可以是 <图像,文本> 对,而 KNN-Diffusion 仅是图像。

- 从定量分析来说,Re-Imagen 在 COCO 数据集上的表现明显优于 KNN-Diffusion。

其他。由于篇幅限制,我们在附录 A 中提供了额外的文献综述。

3. 模型

在本节中,我们从背景知识开始,以简要概述 Imagen 使用的级联扩散模型的形式。 接下来,我们描述如何将检索融入 Re-Imagen 的具体技术细节。 最后,我们讨论交错引导采样。

3.1 预备知识

扩散模型。扩散模型 (Sohl-Dickstein et al., 2015) 是潜变量模型,由 θ 参数化,形式为

![]()

其中 x1,...,xT 是输入图像 x0 ~ q(x0) 的 “有噪” 潜在版本。 请注意,潜在表示和图像的维数在整个过程中是相同的:x_0:T ∈ R^d,d=H*W*C。 计算后验分布 q(x_1:T | x0) 的过程也称为前向(或扩散)过程,并实现为预定义的马尔可夫链,根据时间表 β_t 逐渐向数据添加高斯噪声(马尔可夫链当前时刻状态只与上一时刻有关,各个阶段是独立的,所以联合分布可以写为各个阶段连乘的形式):

通过反转扩散马尔可夫链来训练扩散模型来学习图像分布。 理论上,这可以简化为学习将噪声图像 x_t ~ q(x_t | x0) 去噪为 x0,并具有时间重新加权平方误差损失——完整证明参见 Ho 等人(2020):

![]()

![]()

![]()

其中,x0 是真实图像,c 是条件,ε~N(0,I) 是噪声项。为了简化符号,我们将允许条件 c 包含多个条件信号,例如文本提示 c_p、低分辨率图像输入 c_x(用于超分辨率)或检索到的相邻图像 c_n(用于 Re-Imagen)。 Imagen (Saharia et al., 2022) 使用 U-Net (Ronneberger et al., 2015) 来实现 ε_θ(x_t, c, t)。 U-Net 表示反向噪声生成器如下:

![]()

在训练过程中,我们随机采样 t~U([0,1]),并从数据集 D 中随机采样图像 x0,然后根据公式 2 最小化 ^x_θ (x_t, c) 和 x0 之间的差异。在推理时, 扩散模型使用 DDPM (Ho et al., 2020) 递归采样,如下所示:

模型将 x_T 设置为高斯噪声,T 表示扩散步骤总数,然后不断反向采样,直到步骤 T = 0,达到最终图像 ^x0。

为了获得更好的生成效率,级联扩散模型(Ho et al., 2022; Ramesh et al., 2022; Saharia et al., 2022)使用三个独立的扩散模型逐渐生成高分辨率图像,从低分辨率到高分辨率 。 三种模型 64*64 模型、256*256 超分辨率模型、1024*1024 超分辨率模型逐渐将模型分辨率提高到 1024*1024。

无分类器指导。Ho & Salimans (2021) 首先提出了无分类器指导来权衡多样性和样本质量。 这种采样策略由于其简单性而被广泛使用。 特别是,Imagen (Saharia et al., 2022) 采用调整后的 ε-预测,如下所示:

![]()

其中 w 是指导权重。 无条件预测 ε_θ(x_t, t) 是通过删除条件(即文本提示)来计算的。

3.2 用多模态知识生成图像

主要思想。如图2所示,在去噪过程中,Re-Imagen不仅以文本提示 c_p(以及用于超分辨率的c_x)为条件,还以从外部知识检索到的近邻 c_n 为条件来决定其生成结果。 这里,文本提示 c_p ∈ R^(n*d) 使用 T5 嵌入表示(Raffel et al., 2020),其中 n 是文本长度,d 是嵌入维度。 同时,使用输入提示 p 作为 query 以及检索相似度函数 γ(p,B) 从外部知识库 B 检索 top-k 近邻

![]()

我们对相似性函数尝试了两种不同的选择:BM25 的最大内积分数(Robertson 等人,2009)和 CLIP(Radford 等人,2021)。

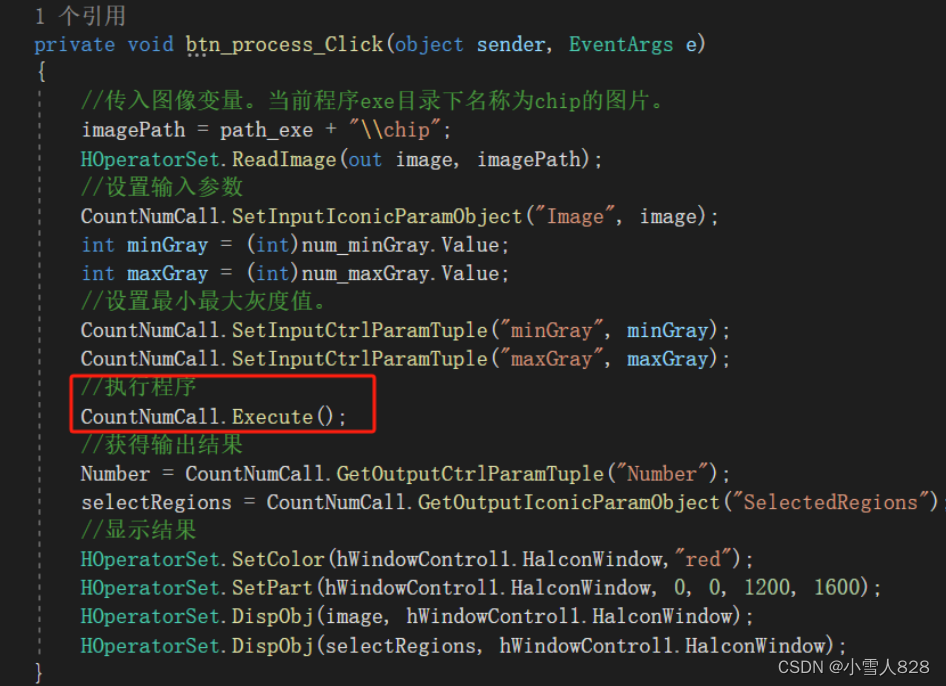

模型架构。我们在图 3 中展示了模型的架构,其中我们将 UNet 分解为下采样编码器 (DStack) 和上采样解码器 (UStack)。 具体来说,DStack 以图像、文本和时间步作为输入,生成特征图,记为

![]()

其中 F 表示特征图宽度,d 表示隐维度(hidden dimension)。 当我们对检索到的 <image, text> 对(t 设置为零)进行编码时,我们共享相同的 DStack 编码器,这会产生一组特征映射

![]()

然后,我们使用多头注意力模块(Vaswani et al., 2017)提取最相关的信息以生成新的特征图

![]()

然后,上采样解码器 UStack 预测噪声项

![]()

并使用它通过公式 3 计算 ^x_θ,该公式可用于训练期间的回归或 DDPM 采样。

模型训练。为了训练 Re-Imagen,我们基于 Imagen 中使用的 50M ImageText 数据集构建了一个新的数据集 KNN-ImageText。

- 选择这个数据集有两个动机。 (1)数据集包含许多关于特定实体的相似照片,这对于获得相似的近邻非常有帮助,(2)数据集经过高度净化,不道德或有害的图像较少。

- 对于 50M ImageText 数据集中的每个实例,我们使用文本到文本 BM25 相似度搜索同一数据集,以找到前 2 个邻居作为 c_n(不包括 query 实例)。

- 我们尝试了 CLIP 和 BM25 相似度评分,并使用 ScaNN 实现检索(Guo et al., 2020)。

- 我们通过最小化方程 2 的损失函数来在 KNN-ImageText 上训练 Re-Imagen。

- 在训练过程中,我们还以 10% 的机会独立地随机丢弃文本和近邻条件。 这种随机丢弃将帮助模型学习边缘噪声项 ε_θ(x_t,c_p,t) 和 ε_θ(x_t,c_n,t),这将用于无分类器指导。

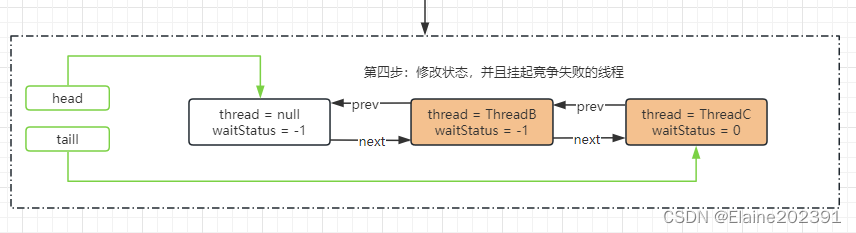

交错的无分类器指导。与现有的扩散模型不同,我们的模型需要处理多个条件,即文本提示 c_t 和检索到的邻居 c_n,这允许了合并指导。 特别是,Re-Imagen 可以通过减去无条件 ε-预测或两个部分条件 ε-预测中的任何一个来使用无分类器指导。 根据经验,我们观察到减去无条件 ε-预测(标准无分类器指导)通常会导致不期望的不平衡,其中输出要么由文本条件主导,要么由邻居条件主导。 因此,我们设计了一个平衡这两个条件的交错指导计划。 正式地,我们将两个调整后的预测定义为:

其中 ^ε_p 和 ^ε_n 分别是文本增强和邻居增强的预测。 这里,w_p 是文本引导权重,w_n 是邻居引导权重。 然后,我们按照某个预定义的比率 η 将两个指导预测交错。 具体来说,在每个引导步骤中,我们采样一个 [0, 1]-均匀随机数 R,并且当 R < η 时,我们使用 ^ε_p,否则使用 ^ε_n。 我们可以进行调整以平衡对应于文本描述或检索到的图像文本对的忠实度。

4. 实验

Re-Imagen 由三个子模型组成:2.5B 64*64文本转图像模型、750M 256*256超分辨率模型和400M 1024*1024超分辨率模型。 我们还有一个带有 1.4B 64*64 文本到图像模型的 Re-Imagen-small 来了解模型大小的影响。

我们在构建的 KNN-ImageText 数据集上微调这些模型。 我们在两种设置下评估模型:(1)在 COCO 和 WikiImages 数据集上自动评估,以衡量模型生成逼真图像的一般性能,以及(2)在新引入的 EntityDrawBench 上进行人工评估,以衡量模型生成长尾(long-tail)实体图像的能力。

训练和评估细节。

- 微调在 64 个 TPU-v4 芯片上运行了 200K 步,并在两天内完成。

- 我们对 64*64 模型使用 Adafactor,对 256*256 超分辨率模型使用 Adam,学习率为 1e-4。

- 我们在训练期间设置邻居数量 k=2 并设置 γ=BM25。

- 对于图像文本数据库 B,我们考虑三种不同的变体:(1)域内训练集,其中包含来自 COCO 或 WikiImages 的非重叠小规模域内图像文本对,(2)域外 LAION 数据集(Schuhmann et al., 2021)包含爬取的 400M <image, text> 对。

- 由于使用 CLIP 编码对 ImageText 和 LAION 进行索引的成本很高,因此我们只考虑用于这些数据库的 BM25 检索器。

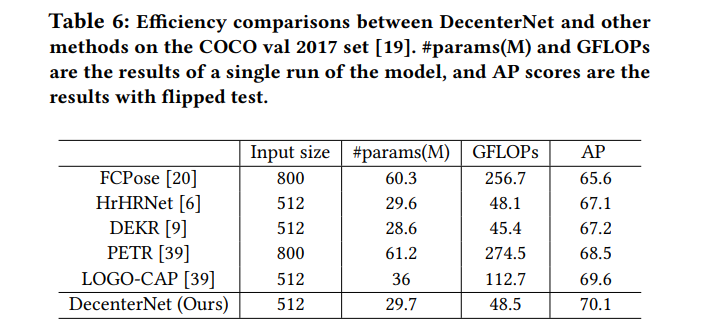

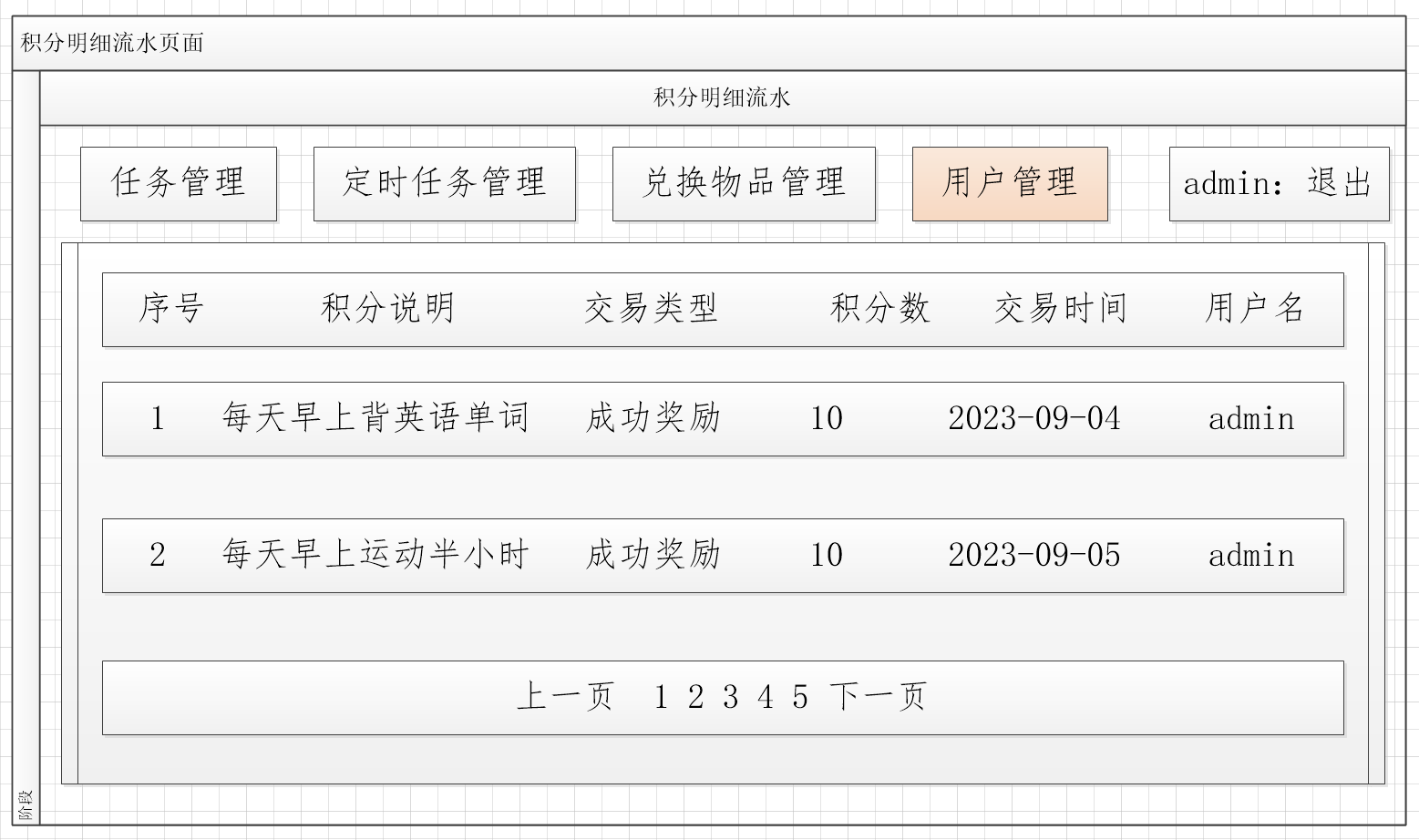

4.1 在 COCO 和 WikiImages 上的评价

在这两个实验中,我们使用标准的非交错无分类器引导,64*64 扩散模型和 256*256 超分辨率模型的步长为 T=1000。64*64 模型的指导权重 w 遍历 [1.0,1.25,1.5,1.75,2.0],而 256*256 超分辨率模型的指导权重 w 遍历 [1.0,5.0,8.0,10.0]。 我们选择具有最佳 FID 分数的指导 w,如表 1 所示。我们还在图 4 中演示了示例。

COCO 结果。

- COCO 是文本到图像生成模型最广泛使用的基准。 尽管 COCO 不包含许多稀有实体,但它确实包含常见实体的不寻常组合,因此检索增强也可能有助于解决一些具有挑战性的文本提示。

- 我们采用 FID (Heusel et al., 2017) 评分来衡量图像质量。

- 遵循之前的文献,我们从验证集中随机抽取 30K 提示作为模型的输入。 将生成的图像与完整验证集 (42K) 中的参考图像进行比较。

- 我们将结果分为两列:FID-30K 表示模型可以访问域内 COCO 训练集,而零样本 FID-30K 则无法访问任何 COCO 数据。

Re-Imagen 可以通过从外部数据库检索来实现 FID 的显着提升:

- 相对于 Imagen 大约有 2.0 的绝对 FID 改进。 其性能甚至比微调的 Make-A-Scene 还要好(Gafni 等人,2022)。

- 我们发现从 OOD 数据库检索的 Re-Imagen 获得的增益低于 IND 数据库,但仍比 Imagen 获得 0.4 FID 的改进。

- 与其他检索增强模型相比,Re-Imagen 的表现优于 KNN-Diffusion 和 Memory-Driven T2I 模型,显着显著提升了 11 FID 分数。

- 我们还注意到,Re-Imagen-small 在 FID 中也能胜任,它的性能优于参数较少的正常大小的 Imagen。

由于 COCO 不包含不常见的实体,因此从域内数据库中检索主要为模型提供有用的 “风格知识”。 Re-Imagen 可以更好地适应 COCO 分布,从而获得更好的FID分数。 从图 4 的上半部分可以看出,带有检索的 Re-Imagen 生成了与 COCO 相同风格的图像,而没有检索,输出仍然是高质量的,但风格与 COCO 不太相似。

WikiImages 结果。

- WikiImages 是基于 Web-QA 中提供的多模态语料库(Chang 等人,2022)构建的,该语料库由从 Wikimedia Commons 抓取的 <图像,文本> 对组成。

- 我们对原始语料库进行了过滤,以去除噪声数据(参见附录 B),从而得到总共 32 万个示例。 我们随机采样 22K 作为验证集来执行零样本评估,我们进一步从数据集中采样 20K 提示作为输入。

- 与之前的实验类似,我们也采用之前的指导权重方案并评估 256*256 张图像。

从表1中,我们发现使用OOD数据库(LAION)实际上比使用IND数据库获得了更好的性能。 与 COCO 不同,WikiImages 包含主要以实体为中心的图像,因此在数据库中查找相关实体的重要性比从训练集中提取样式更重要,而且由于 LAION-400M 的规模比域内数据库大 100 倍 ,检索相关实体的机会要高得多,这会带来更好的性能。 图 4 下半部分描绘了一个示例,其中 LAION 检索发现 “Island of San Giorgio Maggiore”,这有助于模型生成古典文艺复兴风格的教堂。

4.2 EntityDrawBench 上的以实体为中心的评估

数据集构建。我们引入 EntityDrawBench 来评估模型在不同视觉场景中生成不同实体集的能力。

- 具体来说,我们从 Wikipedia Commons、Google Landmarks 和 Fandom 中挑选各种类型的视觉实体(狗品种、地标、食物、鸟类和动画角色)来构建我们的提示。

- 我们总共收集了 250 个以实体为中心的评估提示。 这些提示大多非常独特,我们在网上找不到,更不用说模型训练数据。 数据集构建细节见附录 C。

- 为了评估模型基于更广泛类型实体的能力,我们还随机选择 20 个对象,如“太阳镜、背包、花瓶、茶壶等”,并为它们编写创意提示。

- 我们将我们的生成结果与附录 H 中的 DreamBooth(Ruiz 等人,2022)的结果进行了比较。

我们使用构建的提示作为输入,并将其相应的图像文本对作为 Re-Imagen 的 “检索”,生成四个 1024*1024 图像。

- 对于其他模型,我们也直接输入提示来生成四个图像。

- 我们从 4 个随机样本中挑选出最好的图像,由人类评分者对其照片真实性和忠实度进行评分。

- 对于照片真实感,如果图像适度真实且没有明显的伪影,我们将其评为 1。

- 对于忠实度度量,如果图像忠实于实体外观和文本描述,我们将其评为 1。

EntityDrawBench 结果。我们对 64 个扩散模型使用建议的交错无分类器指导(第 3.2 小节),该模型在文本和邻居条件下在 w=30 的强指导权重下运行 256 个扩散步骤。 对于 256 和 1024 分辨率模型,我们分别使用 5.0 和 3.0 的恒定指导权重,以及 128 和 32 个扩散步骤。4 个 TPU-v4 芯片上的 4 个图像的推理速度为 30-40 秒。 我们在表 2 中展示了我们对真实性和真实感的人类评估结果。

我们可以观察到,Re-Imagen 通常可以实现比现有模型更高的忠实度,同时保持相似的真实感分数。 与我们的主干 Imagen 相比,我们看到忠实度分数提高了约 40%,这表明我们的模型正在关注检索到的知识并将其吸收到生成过程中。

我们根据实体的频率进一步将实体分为“频繁”和“不频繁”类别(前 50% 为“频繁”)。 我们在图 5 中分别绘制了“频繁”和“不频繁”的忠实度得分。我们可以看到,与其他模型相比,Re-Imagen 对输入实体的频率不太敏感,性能仅略有下降。 这项研究反映了文本到图像生成模型在长尾实体上的有效性。 附录 F 中显示了更多生成示例。

4.3 分析

与其他模型的比较我们在图 6 中演示了来自不同模型的一些示例。可以看出,Re-Imagen 生成的图像在文本对齐和实体保真度之间取得了良好的平衡。 与执行就地修改的图像编辑不同,Re-Imagen 可以根据文本指导在几何和语义上转换相邻实体。 作为一个具体示例,Re-Imagen 在草地上生成 Braque Saint-Germain(图 6 中的第二行),其视角与参考图像不同。

检索次数的影响。检索次数 K 是 Re-Imagen 的一个重要因素。 我们改变所有三个数据集的 K 数量,以了解它们对模型性能的影响。 从图 7 中,我们发现在 COCO 和 WikiImages 上,将 K 从 1增加到 4 并不会导致 FID 分数发生太大变化。 然而,在 EntityDrawBench 上,增加 K 将显着提高生成图像的忠实度。 它表明了使用多个图像来帮助基于视觉实体的 Re-Imagen 的重要性。 我们在附录 D 中提供了视觉示例。

文本和实体忠诚度权衡。在我们的实验中,我们发现对文本提示的忠诚度和对检索到的实体图像的忠诚度之间存在权衡。 基于等式 6,通过调整 ,即采样计划中 ^ε_p 和 ^ε_n 的比例,我们可以控制 Re-Imagen 以生成探索这种权衡的图像:减少 η 会增加实体的实体忠实度,但减少 η 文本对齐方式。 我们发现 η=0.5 左右通常是平衡这两个条件的 “最佳点”。

5. 结论

我们提出了 Re-Imagen,一种检索增强扩散模型,并证明了其在生成真实且忠实图像方面的有效性。 我们不仅通过标准基准(即 COCO 和 WikiImage)上的自动 FID 测量,而且通过对新引入的 EntityDrawBench 的人工评估来展示这些优势。 我们进一步证明,我们的模型在从提及稀少实体的文本生成图像方面特别有效。

Re-Imagen 在文本到图像生成方面仍然存在众所周知的问题,我们将在下面对此进行回顾。此外,由于检索增强建模,Re-Imagen 还具有一些独特的局限性。 首先,由于Re-Imagen对检索到的图像文本对很敏感,因此当检索到的图像质量较低时,会对生成的图像产生负面影响。 其次,Re-Imagen 有时仍然无法生成具有高度合成提示(涉及多个实体)的高质量图像。 第三,超分辨率模型仍然无法捕获检索到的实体的低级细节,从而导致视觉失真。 在未来的工作中,我们计划进一步研究上述局限性并解决它们。

6. 道德声明

强大的文本到图像生成模型,即 Imagen(Saharia 等人,2022)和 Parti(Yu 等人,2022),在社会偏见等方面提出了伦理挑战。 Re-Imagen 面临着同样的挑战,因为我们采用了与之前的模型类似的网络规模数据集。

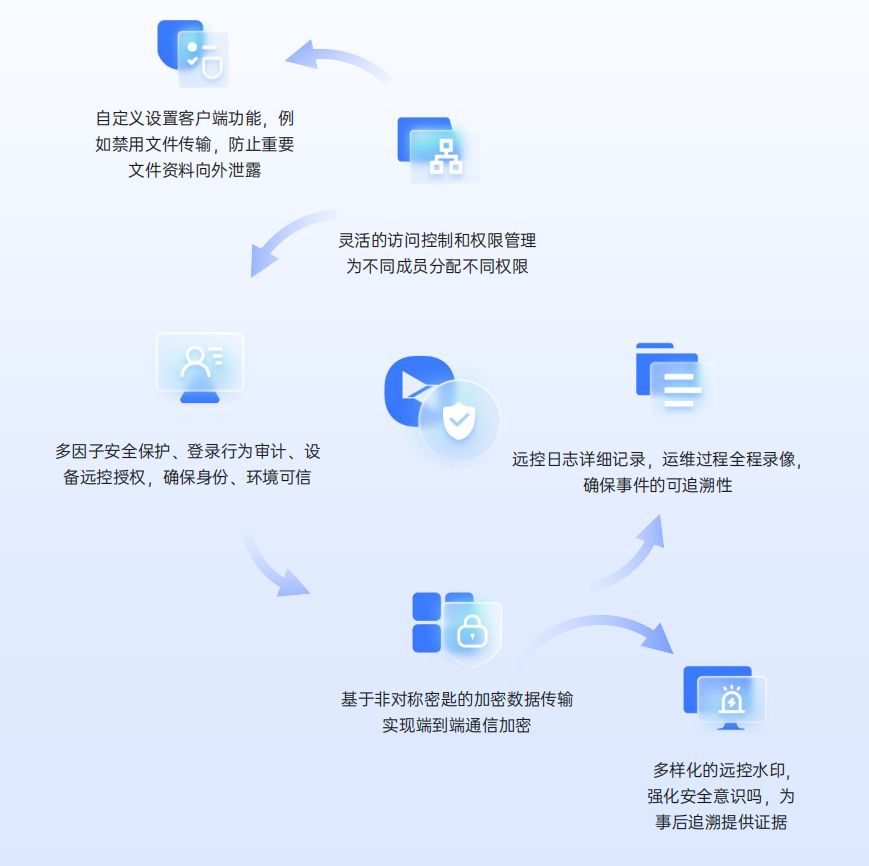

Re-Imagen 的检索增强建模技术极大地提高了生成图像的可控性和归因性。

- 与许多基础研究课题一样,这种额外的控制可以用于有益或有害的目的。

- 一个明显的危险是 Re-Imagen(或类似模型)可能被用于恶意目的,例如传播错误信息,例如在误导性视觉环境中生成特定人物的真实图像。

- 另一方面,额外的控制有许多潜在的好处。 Re-Imagen 的一个普遍好处是可以减少幻想并提高生成的图像对用户意图的忠实度。 另一个好处是,与拖尾实体(tail entities)合作的能力使该模型对较小社区中的少数群体和其他用户更有用:例如,Re-Imagen 在生成较小社区或文化中著名的地标图像以及生成土著食品和文化文物的图像更有效。

- 我们认为该模型可以帮助减少当前基于神经网络的人工智能系统中由出现频率引起的偏差。

考虑到对公众的此类潜在威胁,我们将对代码和 API 的发布持谨慎态度。 在未来的工作中,我们将探索一个负责任使用的框架,平衡研究外部审计的价值与不受限制的开放获取的风险,从而使这项工作能够以安全和有益的方式使用。

参考

Chen W, Hu H, Saharia C, et al. Re-imagen: Retrieval-augmented text-to-image generator[J]. arXiv preprint arXiv:2209.14491, 2022.

附录

A. 延伸文献综述

检索增强生成模型。知识基础也引起了自然语言处理(NLP)社区的广泛关注。

- 不同的半参数模型,如 KNN-LM (Khandelwal et al., 2019)、RAG (Lewis et al., 2020)、REALM (Guu et al., 2020)、RETRO (Borgeaud et al., 2021), 已被提出,将外部文本知识利用到 transformer 语言模型中。

- 这些模型在提高语言模型的可信度和降低计算/内存成本方面表现出了巨大的优势。

- 在图像识别(Long et al., 2022)、二维场景重建(Siddiqui et al., 2021)和图像修复(Xu et al., 2021)等视觉任务中也进行了此类尝试。

- 我们提出的方法遵循相同的主题,将视觉知识合并到预先训练的文本到图像生成模型中,以帮助模型泛化到长尾实体(long-tail entities)甚至未见过的实体,而无需扩大参数。

文本引导的图像编辑。文本引导的图像编辑工作旨在保留对象的外观,同时更改图像中的某些上下文。

- 此前,GAN(Goodfellow 等人,2014)已被用于在图像编辑方面取得显着的性能(Zhu 等人,2016;Abdal 等人,2019;Zhu 等人,2020;Roich 等人,2021; Tov 等人,2021 年;Wang 等人,2022 年;Alaluf 等人,2022 年)。 该问题也称为反演(inversion),因为它通常需要找到生成过程中添加的初始噪声向量。

- 最近,Prompt-to-Prompt(Hertz 等人,2022)建议使用预先训练的文本图像模型进行图像编辑。

- 图像编辑的重点是对输入图像进行就地修改,要么更改全局样式,要么专门编辑局部区域,而不修改对象的外观。 然而,我们将检索到的图像视为 “知识”,并以此为基础合成新图像。 因此,我们不限于就地修改,并且能够对对象执行更复杂的转换。

B. WikiImages 数据集

WikiImages 数据集取自 WebQA(Chang 等人,2022)。 图片是通过 Bing Visual Search API 从 Wikimedia Commons 抓取的。 由于维基媒体的许多主题在视觉上并不有趣,因此作者以自然场景为种子,并逐渐完善搜索池以获得更多有趣的图像。 这些图像主要包含来自维基百科或维基数据的实体。 然而,原始数据集仍然包含大量噪声。 因此,我们应用进一步的过滤来获得更合理的图像生成结果。 具体来说,我们删除所有文本长度大于 15 个标记的图像文本对以及所有带有日期或 wiki-id 信息的文本。

C. EntityDrawBench

- 对于狗品种和鸟类,我们从 Wikipedia Commons 中抽取了 50 种作为候选品种。

- 对于地标,我们从 Google Landmarks(Weyand 等人,2020)中抽取了 50 个作为候选地标。

- 对于食物,我们从 Wikipedia4 中抽取了 50 种作为候选食物。

- 对于电影角色,我们从 Fandom5 收集了 50 张《星球大战》的图像。

我们使用适当配对的源图像作为检索的 “知识”。 对于每个实体(entity)类别,我们编写了 5 个带有实体名称占位符(placeholder)的提示模板,用于描述不同场景下的实体。 每个实体都会对模板进行采样,并用实体的名称替换占位符以生成提示,该提示用作文本到图像生成模型的输入。

我们列出了所有的提示模板,如图 10 所示。

E. 分类器无指导采样策略

我们演示了不同类型的采样策略来利用两种条件:标准联合条件指导采样、加权指导采样和我们提出的交错指导采样。

标准联合条件指导仅考虑联合扩散得分 ε(x_t, c_n, c_p) 来满足这两个条件。 相反,加权引导采样使用文本增强的 ^ε_p 和近邻增强的 ^ε_n 的加权和。 我们的交错分类器指导在 ^ε_p 和 ^ε_n 之间切换,比率为 η : 1-η。 我们在图 12 中绘制了它们的概念差异。本质上,ε_n 和 ε_p 在加权采样中不具有依赖性,但是,它们在交错采样中具有依赖性。 在 ε_n 和 ε_p 相互矛盾的极端情况下,模型将陷入局部区域。 相反,交错采样可以缓解这个问题。

我们在 EntityDrawBench 中比较了这三种采样策略生成的 20 张狗图像。 我们改变扩散步骤的数量来观察他们的人类评估分数曲线,并在图 13 中展示一些生成的输出。可以看出,联合解码要么由检索图像主导,要么由文本提示主导。 加权和交错可以帮助平衡这两个条件以生成更好的图像。 我们还发现,在较少的采样步数 K=200 的情况下,“加权” 采样实际上比 “交错” 采样取得了更好的结果。 然而,随着采样步骤的增加,我们提出的 “交错” 采样取得了更好的人类评估分数。

G. 想象的例子

H. 与 DREAMBOOTH 的比较

我们还添加了与 DreamBooth(Ruiz 等人,2022)的比较。 我们采用与 DreamBooth 几乎相同的输入图像,并在图 17、图 18 和图 19 中显示我们的生成结果。

I. 失败的例子

我们发现 Re-Imagen 在很多情况下也会失败。 我们在图 20 中演示了一些示例。可以看出,该模型有时有一些失败模式:

- 文本输入先验太强,例如 “Zoom” 被模型解释为 “Zoom-in” 图片

- 模型无法基于检索文本接地到检索图像上,例如模型认为只有 “碗里的牛里脊肉” 是 “Escudella”(一种食物),而不是整个炖菜,因此生成 “草地上的牛里脊肉”

- 模型有时会混淆两个条件,例如,提示中的参考“澳大利亚宾莎犬”和“兔子”混合成一个对象。

S. 总结

S.1 主要贡献

本文提出检索增强文本到图像生成模型(Retrieval-augmented Text-to-Image Generator,Re-Imagen),

- 使用检索到的信息作为模型附加输入来生成高保真和忠实的图像,即使对于罕见或未见过的实体也是如此。

- 在去噪过程中,Re-Imagen不仅以文本提示(以及用于超分辨率的低分辨率图像输入)为条件,还以从外部知识检索到的近邻为条件来决定其生成结果,如图 2 所示。

采样过程中交错的无分类器指导,可以在文本指导和检索指导之间切换,以确保文本对齐和实体保真度(对齐),并解决多条件引导不平衡的问题;

引入包含各种视觉实体、提示非常独特(难以找到)、实体具有创意提示的 EntityDrawBench 来评估模型在不同视觉场景中生成不同实体集的能力,并表明 Re-Imagen 可以显着提高对不常见实体的忠实度。

S.2 架构和方法

模型的架构如图 3 所示,其中,将 UNet 分解为下采样编码器 (DStack) 和上采样解码器 (UStack)

- DStack 以图像、文本和时间步作为输入,生成特征图

- 对检索到的 <image, text> 对进行编码产生一组特征映射

- 对如上特征图和特征映射使用多头注意力模块(Vaswani et al., 2017)提取最相关的信息以生成新的特征图

- 对新特征图使用 UStack 预测噪声项,然后使用扩散模型反向噪声生成器生成图像。