Web3和人工智能(AI)的交集,已成为加密社区中最热门的争论话题之一。毕竟,生成式AI正在彻底改变传统软件堆栈的所有领域,Web3也不例外。鉴于去中心化是Web3的核心价值主张,许多新兴的Web3生成AI项目和场景都投射了某种形式的去中心化生成AI价值主张。

在Web3中,我们从去中心化的视角看待每个领域有着悠久的历史,但现实情况是虽然每个领域,都有一系列去中心化场景,但并非所有领域都可以从去中心化中受益,例如人工智能。

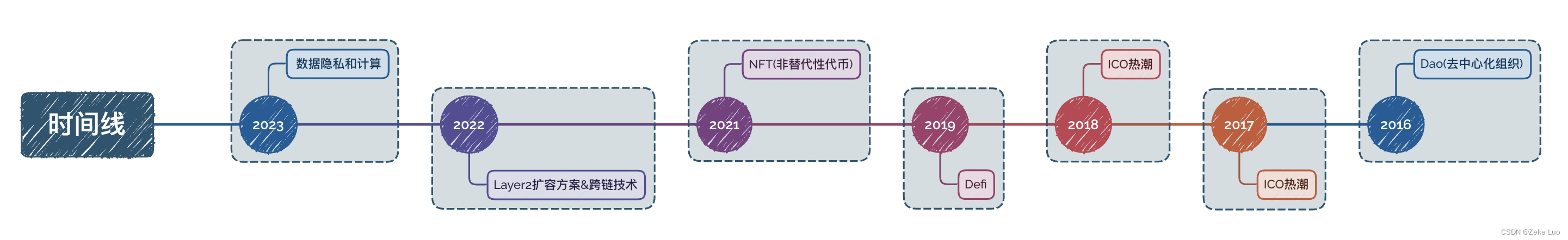

人工智能是数字知识,知识可能是数字世界的第一大结构,值得去中心化。纵观Web3的历史,我们做过许多尝试来去中心化,这些东西在集中式架构中运行得非常好,而去中心化并没有提供明显的好处。

从技术和经济角度看,知识可能不是自然的权力下放候选者之一,因为目前大型人工智能提供商在知识控制方面具有巨大的优势,甚至变得可怕,人工智能的发展已不是线性或指数增长,而是遵循多指数曲线。

GPT-4在许多方面都代表了对GPT3.5的巨大改进,并且这一轨迹可能会继续下去。在某些时候,试图与集中式人工智能提供商竞争变得不可行。一个设计良好的去中心化网络模型可以实现一个生态系统,在这个生态系统中,各方合作以提高模型的质量,从而能够民主地获取知识和分享利益。

此外,透明度是评估人工智能去中心化优点时可以考虑的第二个因素。基础模型架构涉及跨多个层的数百万个互连神经元,因此使用传统的监测实践来理解是不切实际的。没有人真正了解GPT-4内部发生了什么,OpenAI也没有动力在该领域更加透明。去中心化的人工智能网络可以实现开放的测试基准和护栏,提供对基础模型功能的可见性,而无需信任特定的提供商。

如果去中心化人工智能的情况如此清晰,那么为什么我们在这一领域没有看到任何成功的尝试呢?的确,尽管去中心化人工智能的概念早在1990年代就开始出现,但在实践中并没有看到大规模的成功尝试,而这可以归因于多种因素。

在大模型进入场景之前,占主导地位的架构范式是不同形式的监督学习,需要高度策划和标记的数据集,这些数据集主要驻留在公司边界内。此外,这些模型足够小,可以使用主流工具轻松解释。最后,控制的理由也非常薄弱,缺乏强大到足以引起关注的模型。

因此在基础模型向大模型进化这个转折点上,我们开始意识到人工智能需要去中心化,并且与以往的尝试有所不同。现在我们可以开始考虑哪些特定元素需要去中心化,以实现更加公平、可持续和透明的人工智能发展。这需要深入思考和研究,涉及技术、政策和伦理等多个方面。

当涉及到生成式人工智能时,没有单一的去中心化方法。相反,应该在基础模型生命周期的不同阶段的背景下考虑去中心化。

首先,去中心化计算确实在预训练和微调阶段起到关键作用。通过建立去中心化GPU计算网络,不同方可以共同参与模型的训练和优化,减少了云服务提供商对基础模型的垄断控制。

其次,数据去中心化也是非常重要的,特别是在预训练和微调阶段。当前对于用于训练基础模型的数据集的具体组成缺乏透明度,建立分散的数据网络可以促使各方透明地提供数据,并跟踪其在模型训练中的使用情况。

第三,验证是基础模型生命周期中另一个重要的阶段,它需要人工干预和人类反馈。建立分散的人类和人工智能验证网络,可以执行特定任务并追溯结果,将提高验证过程的透明度,从而实现该领域的进一步改进。

最后,构建一个可以分布推理工作负载的网络将是一个有趣的挑战,它可以减少对由集中式方控制的基础架构的依赖,为基础模型的采用带来更大的灵活性和可靠性。

总结

随着人工智能的快速发展,我们面临一个迫切的问题:如何实现人工智能的去中心化,以推动公平、可持续和透明的发展?在解决这个问题的过程中,权力下放被认为是一种最佳的途径,它可以促进创新、多样性和透明度,保护数据隐私,并以更加公正和可持续的方式推动人工智能的发展。

然而,实现这一目标要克服技术、经济和伦理等方面的挑战,需要跨学科的研究和协作,制定合理的政策和机制,才能确保去中心化的人工智能真正造福社会。