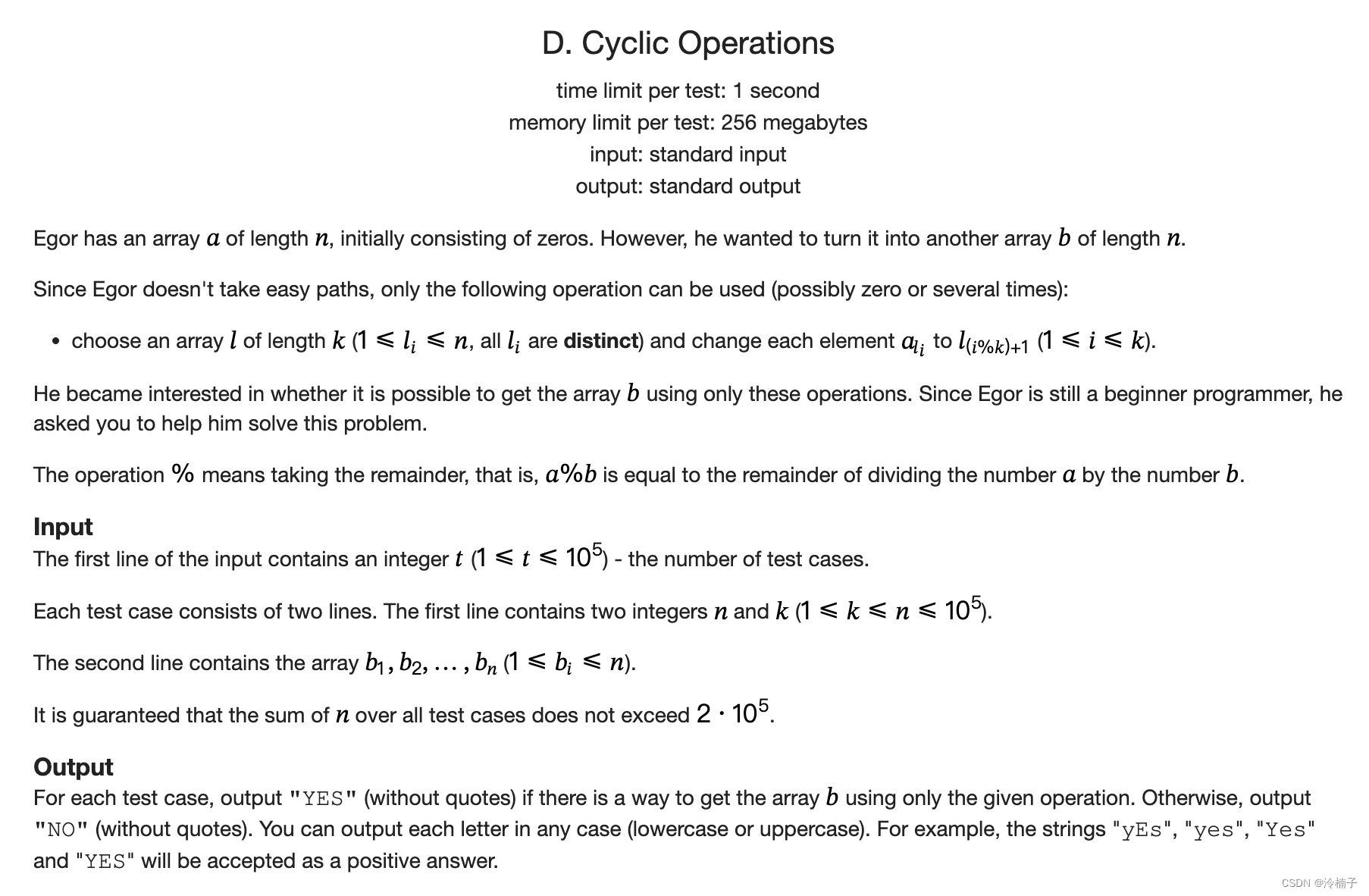

一、查漏补缺、用法分析:

1.这个简单的RNN网络示意图是我看过的最清晰明了的:

2.震惊!原来之前关于seq2seq不明白的地方这里都进行了对应的讲解

02 用字符级别的循环神经网络来判断一个人的名字是哪个国家的常用名 - 知乎 (zhihu.com)

请认真研读这一篇文章,

这里面有些地方还是有些陈旧的,比如,传进model不一定要Variable,现在直接用tensor也可以

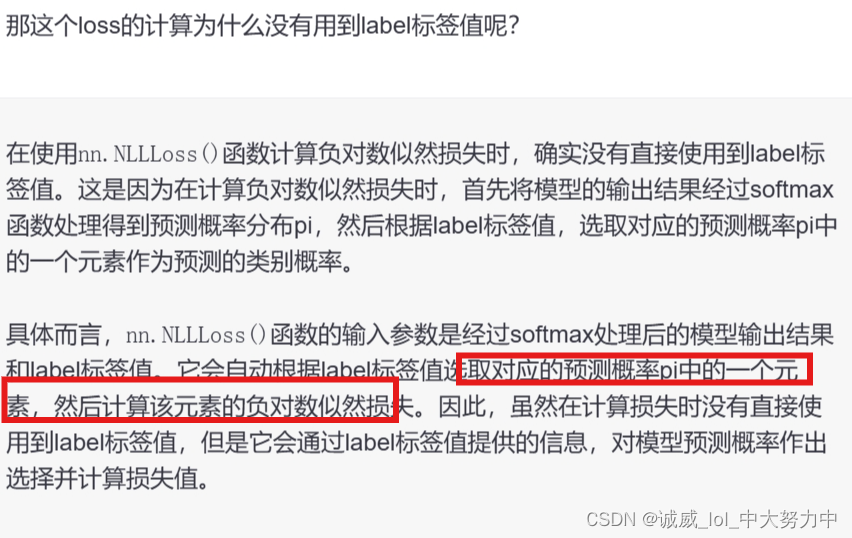

3.关于这个nn.NLLloss的迷惑:

2个参数的维度的关系真的不理解

#没想到,这么做还真可以

criterion = nn.NLLLoss() #设置这个loss_function

test1 = torch.randn(1,18) #1*18维度

print(test1)

#test2 = torch.tensor([100]) #超出0-17,会报错,因为无法转化为one-hot-vec

test2 = torch.tensor([17]) #0-17都相当于是输入了一个one-hot-vec

loss_ = criterion(test1,test2)

print(loss_)

test3 = torch.randn(1,4)

test4 = torch.tensor([0,0,1,0]) #下面报错了

#loss2 = criterion(test3,test4)

#print(loss2)#以下证明一件事情,就是MSE的loss计算的第二个参数,可以是一个one-hot-vec

#也可以是对应的索引位置(内部自动转化为one-hot-vec)不对!!! 而是,用1个数值,和其他所有数值进行计算

loss_func = nn.MSELoss()

test1 = torch.tensor([[0.1,0.2,0.3]])

test2 = torch.tensor([2]) #这个的计算公式就是(1.9*1.9 + 1.8*1.8 +1.7*1.7)/3 = 3.2467

#这个2也可以改成5

test3 = torch.tensor([[0,0,1]]) #这个的计算公式就是(0.1*0.1 + 0.2*0.2 + 0.7*0.7)/3 = 0.18

loss1 = loss_func(test1,test2)

loss2 = loss_func(test1,test3)

print(loss1)

print(loss2)

算了,不纠结了,以后再遇到再说吧,哎,真的奇葩

二、代码:

NLP From Scratch: Classifying Names with a Character-Level RNN — PyTorch Tutorials 2.0.1+cu117 documentation

用它的这个就可以了